Uudet tekoälyratkaisut ovat ihmeellisiä silloin kun ne toimivat – kunnes ne eivät toimi. Vaikka uusilla ratkaisuilla, esimerkiksi ChatGPT:llä tai Co-Pilotilla voi tehdä toinen toistaan hämmentävämpiä asioita, usein tekoälyratkaisut tuottavat myös virheellisiä tuloksia. Monesti ne eivät myöskään vain toimi sillä tavalla kuin luulisi.

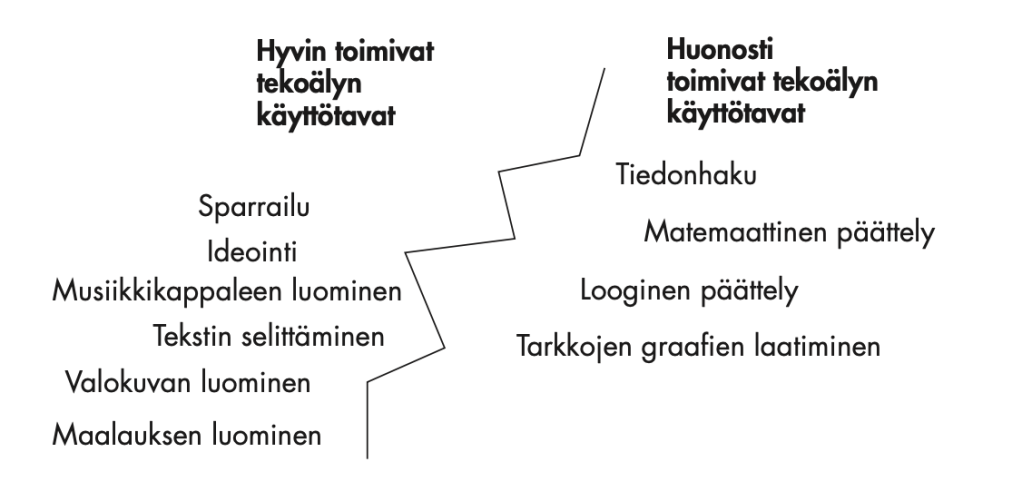

Tekoälyn käytössä keskeisessä roolissa onkin kyky tunnistaa oman toimialasi tekoälyn sahalaitainen raja.

Se tarkoittaa epätarkkaa rajaa sen välillä, mihin tekoälyä kannattaa juuri sinun työssäsi käyttää ja missä ei. Yleensä hyviä käyttötapoja ovat esimerkiksi suunnittelu ja ideointi. Huonoja puolestaan tiedonhaku ja päättely. Kuitenkin viime aikoina esimerkiksi Deep Research -mallit ovat ensimmäistä kertaa tehneet tekoälyratkaisuista riittävän luotettavia, että niitä voi myös käyttää joillakin toimialoilla tiedon kartoittamiseen. Samaten päättelytekoälyt pystyvät jo ajoittain hyvinkin taitavaan järkeilyyn – paitsi silloin kun eivät pysty.

Tekoälyratkaisujen sahalaitainen raja.

Tekoälyratkaisuille on jo nyt osoitettu lukuissisa tutkimuksissa kymmenien prosenttien hyötyjä tuottavuudessa, luovuudessa ja jopa työhyvinvoinnissa. Kuitenkin esimerikiksi Upworkin viimesyksyisessä kyselyssä 2500 vastaajasta 77% koki, että tekoälyn käyttöönotto on laskenut kokonaistuottavuutta. Aikaa tuhrautuu uusien ratkaisujen opiskeluun ja tekoälyn virheiden korjailuun.

Pahimmillaan tämä on organisaatioissa, joissa on vaan lätkäisty päälle Co-Pilot tai Google Workspace AI -tilaus ja pidetään sitten peukkuja, että kaikki sujuu hyvin. Usein ei suju.

Yksilötasolla tekoälyn käyttöä voi harjoitella vaikkapa Tekoälyn pikaoppaan ohjeiden mukaan. Organisaatiotasolla tekoälyn sujuva käyttöönotto edellyttää kuitenkin taitavaa strategista ajattelua.

Ensiksi, organisaation johdon täytyy tutustua riittävän yksityiskohtaisesti uusimpiin ratkaisuihin ja opetella ymmärtämään, miten nämä vimpaimet oikeasti toimivat. Tekoäly ei ole taikarobotti, joka korvaa ihmisen – vaan tilastollinen järjestelmä, joka oikein käytettynä voi laajentaa merkittävästi ihmisen ajattelu- ja toimintakapasiteettia.

Toiseksi, tekoälyn käyttöönotto ei kuulu IT-osastolle – vaan toimivalle johdolle. Johdon täytyy ensin määritellä ne strategiset tavoitteet, joihin tekoälyltä toivotaan lisätukea. Halutaanko esimerkiksi markkinointia tehostaa teksti- ja kuvatekoälyillä? Halutaanko asiakasrajapintaan uusia bottiratkaisuja? Halutaanko tiimien työn suunnittelua tukea päättelytekoälyillä? Halutaanko yrityksen markkinatilannetta seurata tutkimustekoälyillä?

Kolmanneksi, kun tekoälyn tukemat strategiset tavoitteet on määritelty, täytyy valita oikeat tekoälyratkaisut tukemaan tavoitteita. Esimerkiksi Microsoftin ja Googlen toimistotekoälyt voivat tukea merkittävästi tekstin tuottamista tai presentaatioiden laatimista – mutta luovassa sparrailussa tai suunnittelussa ne jäävät johtavien kielimallibottien jalkoihin. Kuvanluonnissa on puolestaan käynnissä jatkuva kilpajuoksu erityisesti OpenAI:n ja Midjourneyn välillä, puhumattakaan videoista, musiikista ja äänestä.

Neljänneksi, tekoälyn käyttöönotto kannattaa tehdä organisaatiossa hallitusti ja systemaattisesti. Uudet ratkaisut kannattaa aluksi testata pienemmillä pilottiryhmillä. Samalla kun uudet ratkaisut siirtyvät käyttöön, kannattaa käyttöönottoa tukea järjestämällä esimerkiksi kuukausittain tai kvartaaleittain ”best practices” -tilaisuuksia. Näissä työntekijät voivat verrata positiivisia ja negatiivisia kokemuksiaan toimialakohtaisesti ja jakaa parhaita vinkkejä tekoälyn hyödyntämiseen. Tätä osaamisen jakamista voi myös tukea arjessa järjestämällä parhaille vinkeille – ja pahimmille sudenkuopille – vaikkapa oman Teams- tai Slack-kanavan.

Oikein käytettynä uudet tekoälyratkaisut mahdollistavat merkittäviä tuottavuusloikkia ja ne voivat myös lisätä työhyvinvointia. Se, mitä oikein käyttäminen kussakin organisaatiossa tai kullakin toimialalla tarkoittaa selviää kuitenkin vain yhdistämällä rohkeat kokeilut kriittiseen arviointiin.

Tekoälyn strateginen käyttöönotto edellyttää siis ymmärrystä siitä, mihin vimpainta oikeasti tarvitaan; siitä, mitkä ratkaisut parhaiten soveltuvat mihinkin tehtävään; ja siitä, miten oman organisaation työntekijät todellisuudessa pääsevät uusista ratkaisuista hyötymään.