Suomen toimintaympäristö muuttuu yhä ennakoimattomammin teknologisten, geopoliittisen ja taloudellisten murrosten seurauksena. Työmarkkinoiden murroksiin varautuminen edellyttää vahvaa ymmärrystä siitä, että epävarmuus on pysyvä olosuhde, ei poikkeus. Yhteiskunnan keskeisin tulevaisuusvalmius on siis kyky sopeutua muutoksiin ja hyödyntää niitä.

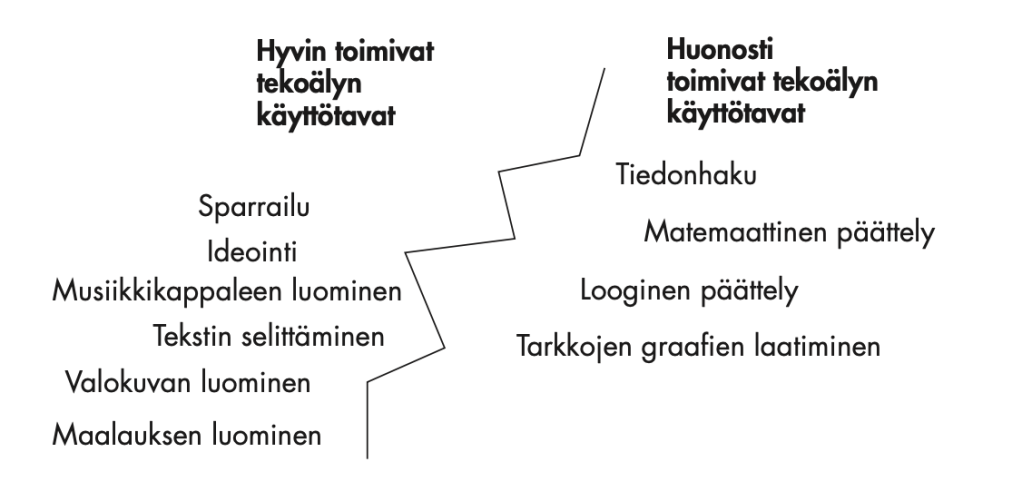

Teknologiamurrokset – erityisesti generatiivinen tekoäly – muuttavat työelämän rakenteita nopeasti. Muutokset kohdistuvat yksittäisiin työtehtäviin, mikä tekee osaamistarpeiden ennakoinnista vaikeaa. Samalla suurten vaikutusten ennakoimattomat tai epätodennäköiset tapahtumat (mustat ja harmaat joutsenet) näyttävät tihentyvän. Tämä korostaa tarvetta lisätä rakenteellista muutoskyvykkyyttä.

Suomen resilienssi on kansainvälisesti vahva, mutta antifragiliteettia – kykyä hyödyntää sokkeja ja muutoksia uusien mahdollisuuksien luomiseen – voidaan vahvistaa merkittävästi. Tähän voidaan vaikuttaa erityisesti:

- varmistamalla kaikkien pääsy jatkuvaan oppimiseen,

- nopeuttamalla nousevien teknologioiden käyttöönottoa,

- tukemalla yrittäjyyttä ja innovaatiotoimintaa, ja

- lisäämällä työmarkkinoiden ja sosiaaliturvan joustavuutta.

Keskeinen suositus on siirtää tulevaisuuspolitiikan painopiste muutoskyvykkyyden vahvistamiseen. Kun yhteiskunnalliset rakenteet tukevat jatkuvaa oppimista, nopeaa sopeutumista ja innovaatioita, Suomi ei ainoastaan selviydy tulevista murroksista, vaan voi myös hyödyntää ne uuden kasvun ja kilpailukyvyn lähteinä.

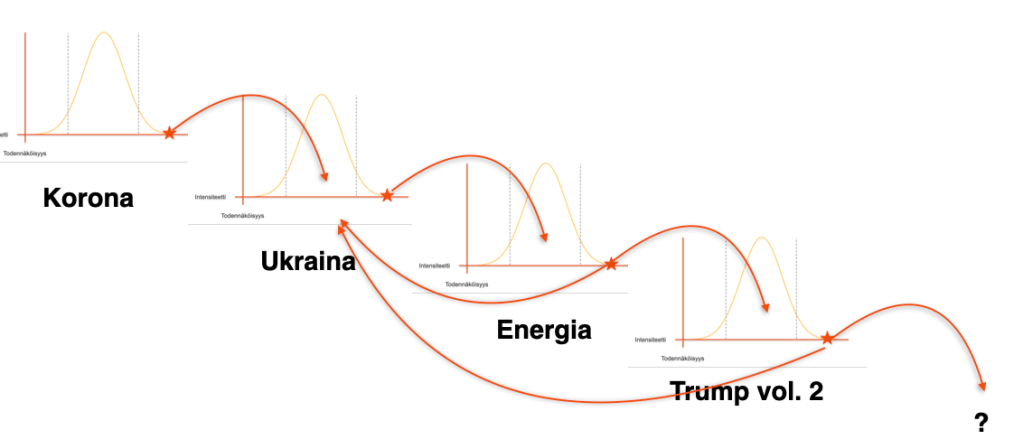

Ongelman ydin on siinä, ettei kukaan osaa ennalta määritellä, mitkä osaamisalueet ovat tarkkaan ottaen disruptiouhan alaisia. Itse asiassa niin sanottujen mustien ja harmaiden joutsenten – eli ennustamattomien tai erittäin epätodennäköisten suurten vaikutusten tapahtumien – esiintymissykli näyttää myös kiihtyvän. Jo nyt 2000-luvun aikana tällaisia murrostapahtumia on esiintynyt lähes yhtä paljon kuin koko 1900-luvulla yhteensä.

Aiempia mustia ja harmaita joutsenia ovat muun muassa sosiaalisen median nousu, koronapandemia ja generatiivinen tekoäly. On luultavaa, että seuraava tällainen suurten vaikutusten tapahtuma tapahtuu 1–3 vuoden sisällä. Koska musta joutsen -tapahtumia ei voida ennustaa ja harmaa joutsen -tapahtumienkin toteutuminen on erittäin epätodennäköistä, on selvää, ettei kaikkiin tällaisiin skenaarioihin voidaan valmistautua.

Lisäksi on myös näkyvillä olevia potentiaalisia kriisejä, vaikkapa yleistekoälyn (AGI) kehittäminen tai USA-Kiina -suhteiden eskalaatio, joihin suhteessa yhteiskunnallinen valmiutemme on melko heikko. Onnistuessaan esimerkiksi yleistekoäly saattaisi käytännössä keskittää lähes kaiken asiantuntijatyön arvon pääasiassa palveluntuottajayrityksille, ja sen vaikutus työmarkkinarakenteisiin ulottuisi kaikkeen tietotyöhön. Jotkut asiantuntijat arvioivat tällaisten ratkaisujen olevan mahdollisia jo 5 vuoden sisällä.

On siis lähes varmaa, että lähitulevaisuudessa kohtaamme jälleen suuren kriisin tai disruption, johon emme ole ennalta varautuneet. Mustat joutsenet eivät ole enää vain villejä kortteja, vaan ne ovat normaali osa nykyistä toimintaympäristöä. Kuten Peter Hinssen totesi Nordic Business Forumissa 2025, maailma ei ole enää “new normal”, vaan olemme siirtyneet aikakauteen, jonka määritelmä on “never normal”.

Johtuen markkinoiden ja työmarkkinoiden ennakoimattomasta kehittymisestä parhaiten erilaisiin tulevaisuusskenaarioihin valmistaudumme erityisesti lisäämällä yhteiskunnan resilienssiä ja antifragiliteetia. Tämä onnistuu panostamalla sellaisiin yhteiskuntarakenteisiin ja käytäntöihin, jotka lisäävät jatkuvaa oppimista, uusien teknologioiden nopeaa käyttöönottoa, innovaatiokyvykkyyttä ja työmarkkinoiden dynaamisuutta.

Luultavasti mikään tulevaisuuteen kohdistuva ennustuksemme ei sellaisenaan toteudu. Sen sijaan tulevaisuudenkestävää yhteiskuntaa rakennetaan vahvistamalla kansallista muutoskyvykkyyttämme – siis taitoja ja kyvykkyyksiä joiden avulla emme vain selviä muutoksista vaan voimme myös kääntää ne uuden kasvun ja kehityksen mahdollisuuksiksi.

Teksti on ote marraskuussa 2025 sivistysvaliokunnalle kirjoittamastani lausunnosta koskien valiokunnan tulevaisuusselontekoa. Lue koko lausunto täältä.